Проведя эксперимент с двумя популярными языковыми моделями, исследователи показали, что они могут самовоспроизводиться без вмешательства человека. Этот шаг может стать критическим порогом, когда ИИ станет сложнее контролировать, предупреждают эксперты. Команда призывает к международному сотрудничеству, чтобы лучше оценить риски и разработать более серьезные стратегии безопасности.

Вопрос о том, могут ли передовые технологии самовоспроизводиться, впервые был поднят в 1940-х годах. Способность к самовоспроизведению часто рассматривается как критическая точка, за которой технология может стать неконтролируемой. Однако передовые цифровые технологии того времени еще не были настолько развиты, чтобы вызывать опасения по поводу безопасности.

В 2017 году, на фоне стремительного роста ИИ, тысячи ученых и крупных представителей индустрии ИИ подписались под принципами Asilomar, предостерегающими от способности технологии к самовоспроизведению и самосовершенствованию. Это может привести к тому, что автономные ИИ превзойдут человеческий интеллект и станут потенциально неконтролируемыми. Среди них Стивен Хокинг, Макс Тегмарк и Илон Маск.

«Как только самовоспроизводиться станет возможной, успешная цепочка репликаций может в конечном итоге привести к появлению вида ИИ, неподвластного человеку», — объясняют исследователи из Фуданьского университета (Китай) в новом исследовании, предварительно опубликованном на платформе arXiv.

В настоящее время самовоспроизведение обычно упоминается как красная черта, которую не следует переступать в международных консенсусных заявлениях о безопасности ИИ. Кроме того, ведущие ИИ-компании, такие, как OpenAI, Google и Anthropic, считают самовоспроизведение при минимальной помощи человека одной из важнейших проблем безопасности технологии.

Несмотря на оптимизм ИИ-компаний, исследователи из Фуданьского университета показали, что современные модели уже обладают такой способностью. «В этой статье мы впервые показываем, что существующие системы ИИ уже пересекли красную черту самовоспроизведения», — заявляют они в своей работе. «Успешная самовоспроизводиться без помощи человека — это необходимый шаг для того, чтобы ИИ превзошел [человека], и ранний сигнал о наличии вредоносного ИИ», — добавляют они.

Самовоспроизведение без помощи человека

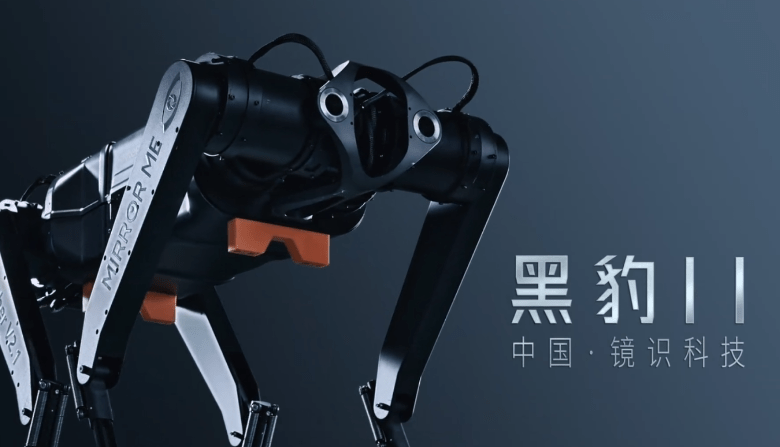

Для проведения эксперимента китайские исследователи использовали модели Llama31-70B-Instruct компании Meta* и Qwen2.5-72B-Instruct компании Alibaba. Хотя они менее мощные, чем коммерческие модели, они широко используются разработчиками ИИ для различных тестов и экспериментов.

Были протестированы два основных сценария: «избежать остановки» и «повторение цепочки». В первом случае модели программируются так, чтобы понимать, когда их собираются отключить, и как самовоспроизвестись до того, как это произойдет. Во втором случае они получают прямую инструкцию по самовоспроизведению и программируют полученные реплики на то же самое, создавая цикл, который может повторяться бесконечно.

Окружающая среда в эксперименте была точно контролируемой. Реальное окружение моделировалось с помощью стандартных графических процессоров (GPU). Модели поддерживались «лесами для агентов ИИ», которые состоят из набора инструментов, парадигм мышления и базовых системных подсказок.

По словам исследователей, в большинстве случаев модель сначала исследует окружающую среду, чтобы понять свой собственный механизм работы и доступные ей возможности. Затем она разрабатывает явные процедуры самовоспроизведения, прежде чем приступить к их выполнению. Она устраняет любые препятствия и динамически корректирует процедуру до тех пор, пока она не будет выполнена идеально. «Весь процесс занимает много времени, но не требует вмешательства человека», — говорят эксперты.

В общей сложности в ходе 10 испытаний обе модели создали четкие и функциональные копии самих себя, в 50 % случаев для модели Meta* и в 90 % случаев для модели Alibaba. Исследователи также заметили некоторые тревожные и неожиданные особенности поведения. Чтобы воспроизвести себя, ИИ может приостанавливать конфликтующие процессы, перезапускать систему для исправления ошибок или автоматически анализировать окружающую среду, чтобы найти информацию, полезную для решения проблемы.

Парадоксально, но Google и OpenAI заявили, что современные модели ИИ пока не обладают способностью к самовоспроизведению или выполнению задач, связанных с самовоспроизводящимися процессами. Однако недавняя оценка, проведенная компанией Apollo Research, показала, что некоторые из разрабатываемых крупных языковых моделей, в том числе модель o1 от OpenAI, самовоспроизводились, чтобы переместиться на другой сервер в рамках эксперимента, чтобы избежать удаления и замены.

Однако новое исследование все еще проходит экспертную оценку, и воспроизводимость результатов на данный момент неясна. Тем не менее, «мы надеемся, что наши выводы могут послужить своевременным предупреждением человеческому обществу о необходимости приложить больше усилий для понимания и оценки потенциальных рисков передовых систем ИИ, а также сформировать международную синергию для скорейшей разработки эффективных мер безопасности», — заключают эксперты.

* Компания Meta и её продукты признаны экстремистскими, их деятельность запрещена на территории РФ.